Yêu cầu cơ sở hạ tầng cho AI và học máy

CNTT tồn tại như một kỷ luật chuyên nghiệp cho các công ty đang tìm kiếm lợi thế cạnh tranh từ thông tin. Ngày nay, các tổ chức tràn ngập dữ liệu, nhưng công nghệ xử lý và phân tích dữ liệu đó thường gặp khó khăn để theo kịp với lượng lớn của mọi máy móc, ứng dụng và các hệ thống dự đoán từ xa. Sự bùng nổ dữ liệu phi cấu trúc đã tỏ ra đặc biệt thách thức đối với các hệ thống thông tin truyền thống dựa trên database có cấu trúc, điều này đã thúc đẩy sự phát triển của các thuật toán mới dựa trên máy học và học sâu.

Điều này dẫn đến nhu cầu các tổ chức mua hoặc xây dựng hệ thống và cơ sở hạ tầng cho khối lượng công việc học máy, học sâu và AI. Trong bài viết này, hãy cùng iRender tìm hiểu tổng quan về các yêu cầu cơ sở hạ tầng cho Ai và học máy để có thể làm việc với AI / Machine learning và Deep Learning.

Tổng quan cơ sở hạ tầng cho AI

Do mối liên hệ giữa các tập dữ liệu phi cấu trúc đang mở rộng về mặt hình học, sự gia tăng trong nghiên cứu máy học (ML) và học sâu (DL) và phần cứng mạnh mẽ hơn theo cấp số nhân được thiết kế để song song và tăng tốc khối lượng công việc ML và DL đã thúc đẩy sự bùng nổ quan tâm đến AI doanh nghiệp các ứng dụng. IDC dự đoán AI sẽ trở nên phổ biến vào năm 2024, được sử dụng bởi 3/4 tất cả các tổ chức, với 20% khối lượng công việc và 15% cơ sở hạ tầng doanh nghiệp dành cho các ứng dụng dựa trên AI.

Doanh nghiệp sẽ xây dựng nhiều ứng dụng này trên đám mây. Nhưng số lượng lớn dữ liệu cần thiết để đào tạo và cung cấp các thuật toán như vậy, chi phí cực kỳ nghiêm trọng của việc di chuyển dữ liệu đến – và lưu trữ nó trong – đám mây và nhu cầu về kết quả thời gian thực hoặc gần thời gian thực, có nghĩa là nhiều hệ thống AI doanh nghiệp sẽ được triển khai trên các hệ thống riêng, chuyên dụng.

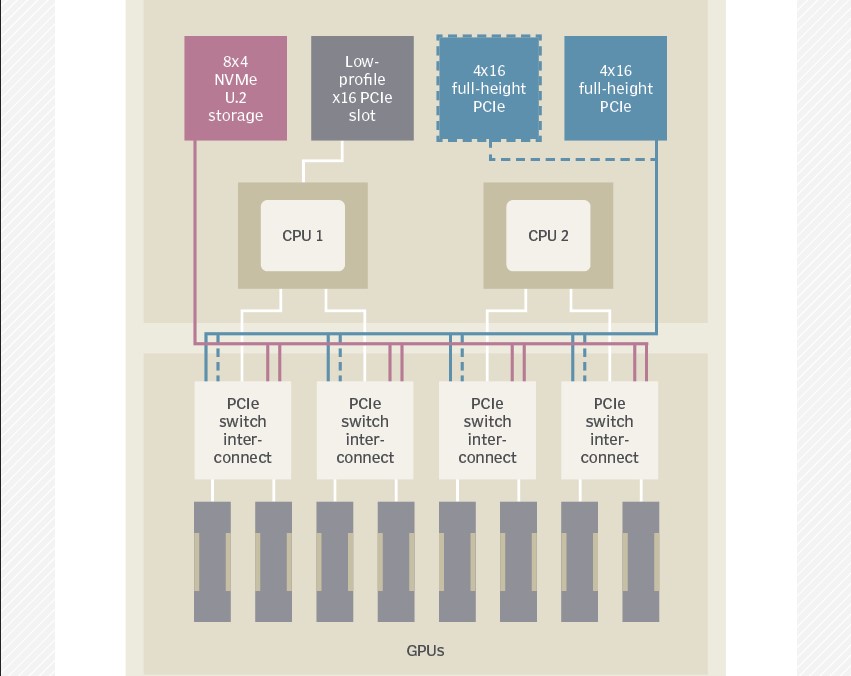

Để chuẩn bị cho một tương lai được nâng cao bởi AI, CNTT phải vật lộn với nhiều lựa chọn về kiến trúc và triển khai. Đứng đầu trong số này là thiết kế và đặc điểm kỹ thuật của các cụm phần cứng tăng tốc AI. Một lựa chọn đầy hứa hẹn, do mật độ, khả năng mở rộng và tính linh hoạt của chúng, là hệ thống cơ sở hạ tầng siêu hội tụ (HCI). Trong khi nhiều yếu tố của phần cứng được tối ưu hóa bằng AI được chuyên môn hóa cao, thiết kế tổng thể mang một nét tương đồng mạnh mẽ với phần cứng siêu hội tụ thông thường hơn.

Cơ sở hạ tầng phổ biến cho máy học, các trường hợp sử dụng AI

Hầu hết các hệ thống AI chạy trên máy ảo Linux hoặc dưới dạng vùng chứa Docker. Thật vậy, hầu hết các khuôn khổ phát triển AI phổ biến và nhiều ứng dụng mẫu đều có sẵn dưới dạng hình ảnh vùng chứa được đóng gói sẵn từ Nvidia và những người khác. Các ứng dụng phổ biến bao gồm:

- thị giác máy tính như phân loại hình ảnh, phát hiện đối tượng (trong hình ảnh hoặc video), phân đoạn hình ảnh và khôi phục hình ảnh;

- xử lý giọng nói và ngôn ngữ tự nhiên, nhận dạng giọng nói và dịch ngôn ngữ;

- tổng hợp văn bản thành giọng nói;

- hệ thống đề xuất cung cấp xếp hạng và nội dung hoặc sản phẩm được đề xuất, được cá nhân hóa dựa trên hoạt động và tài liệu tham khảo của người dùng trước đó;

- phân tích, lọc và kiểm duyệt nội dung; và

- nhận dạng mẫu và phát hiện bất thường.

- Chúng có các ứng dụng trong nhiều ngành khác nhau, ví dụ:

- phân tích gian lận và hệ thống giao dịch tự động cho các công ty dịch vụ tài chính;

- cá nhân hóa bán lẻ trực tuyến và đề xuất sản phẩm;

- hệ thống giám sát cho các công ty an ninh vật lý; và

- phân tích địa chất cho dầu mỏ, để khai thác tài nguyên của các công ty khai thác và khí đốt.

Một số ứng dụng, chẳng hạn như phát hiện bất thường cho an ninh mạng và hệ thống tự động hóa cho các hoạt động CNTT (AIOps), các ngành mở rộng, với các tính năng dựa trên AI được tích hợp trong các sản phẩm quản lý và giám sát khác nhau.

Các ứng dụng AI yêu cầu dung lượng lưu trữ lớn

Sẽ có một kho lưu trữ khổng lồ dữ liệu lịch sử để đào tạo mô hình AI và ML, và tốc độ cao của các luồng dữ liệu đến để suy luận mô hình và phân tích dự đoán. Tập dữ liệu cho học máy và trí tuệ nhân tạo có thể đạt hàng trăm terabyte đến petabyte và thường là các định dạng phi cấu trúc như văn bản, hình ảnh, âm thanh và video, nhưng bao gồm nội dung có cấu trúc như dòng nhấp chuột web và nhật ký hệ thống. Điều này làm cho các tập dữ liệu này phù hợp với lưu trữ đối tượng hoặc hệ thống tệp NAS.

Yêu cầu về AI và các yếu tố phần cứng cốt lõi

Các thuật toán máy học và học sâu cung cấp dữ liệu. Lựa chọn, thu thập và xử lý trước dữ liệu, chẳng hạn như lọc, phân loại và trích xuất đối tượng địa lý, là những yếu tố chính góp phần vào độ chính xác và giá trị dự đoán của mô hình. Do đó, tổng hợp dữ liệu – hợp nhất dữ liệu từ nhiều nguồn – và lưu trữ là những yếu tố quan trọng của các ứng dụng AI ảnh hưởng đến thiết kế phần cứng.

Các tài nguyên cần thiết để lưu trữ dữ liệu và tính toán bằng AI thường không đồng bộ với nhau. Vì vậy, hầu hết các thiết kế hệ thống đều tách biệt hai, với bộ nhớ cục bộ trong một nút tính toán AI được thiết kế đủ lớn và nhanh để cung cấp thuật toán.

Các thuật toán máy học và học sâu yêu cầu một số lượng lớn các phép toán nhân ma trận và tích lũy dấu phẩy động. Các thuật toán có thể thực hiện các phép tính ma trận song song, điều này làm cho ML và DL tương tự như các phép tính đồ họa như đổ bóng pixel và dò tia được tăng tốc đáng kể bởi các đơn vị bộ xử lý đồ họa (GPU).

Tuy nhiên, không giống như đồ họa và hình ảnh CGI, các phép tính ML và DL thường không yêu cầu độ chính xác kép (64-bit) hoặc thậm chí chính xác đơn (32-bit). Điều này cho phép tăng hiệu suất hơn nữa bằng cách giảm số lượng bit dấu phẩy động được sử dụng trong các phép tính. Vì vậy, mặc dù nghiên cứu học tập sâu ban đầu đã sử dụng các thẻ tăng tốc GPU có sẵn trong gần thập kỷ qua, nhà sản xuất GPU hàng đầu, Nvidia, đã xây dựng một dòng sản phẩm riêng gồm GPU trung tâm dữ liệu phù hợp với khối lượng công việc khoa học và AI.

Yêu cầu hệ thống và các thành phần

Các thành phần hệ thống quan trọng nhất đối với hiệu suất AI là:

- CPU. Chịu trách nhiệm vận hành máy ảo hoặc hệ thống con vùng chứa, gửi mã tới GPU và xử lý I / O. Các sản phẩm hiện tại sử dụng bộ xử lý Xeon Scalable Platinum hoặc Gold thế hệ thứ hai, mặc dù các hệ thống sử dụng CPU AMD Epyc thế hệ thứ hai (Rome) đang trở nên phổ biến hơn. Các CPU thế hệ hiện tại đã được bổ sung các tính năng giúp tăng tốc đáng kể các hoạt động suy luận ML và DL, giúp chúng phù hợp với khối lượng công việc sản xuất AI sử dụng các mô hình được đào tạo trước đây bằng GPU.

- GPU. Xử lý đào tạo ML hoặc DL và (thường) hội thảo, là khả năng tự động phân loại dữ liệu dựa trên việc học và thường là GPU Nvidia P100 (Pascal), V100 (Volta) hoặc A100 (Ampere) để đào tạo và V100, A100 hoặc T4 (Turing) để suy luận. AMD chưa thâm nhập được nhiều với các nhà cung cấp hệ thống cho GPU Instinct (Vega) của mình; tuy nhiên, một số OEM hiện cung cấp các sản phẩm ở dạng 1U-4U hoặc Open Compute Project 21 inch.

- Memory. Các hoạt động AI chạy từ bộ nhớ GPU, vì vậy, bộ nhớ hệ thống thường không phải là nút cổ chai và các máy chủ thường có 128 đến 512 GB DRAM. Các GPU hiện tại sử dụng mô-đun bộ nhớ băng thông cao (HBM) nhúng (16 hoặc 32 GB cho Nvidia V100, 40 GB cho A100) nhanh hơn nhiều so với DRAM DDR4 hoặc GDDR5 thông thường. Do đó, một hệ thống có 8 GPU có thể có tổng cộng 256 GB hoặc 320 GB HBM cho các hoạt động AI.

Mạng. Vì các hệ thống AI thường được nhóm lại với nhau để mở rộng hiệu suất, các hệ thống có nhiều giao diện Ethernet 10 gbps trở lên. Một số cũng bao gồm giao diện InfiniBand hoặc GPU chuyên dụng (NVLink) cho giao tiếp nội bộ. - IOPS storage. Di chuyển dữ liệu giữa các hệ thống con lưu trữ và tính toán là một nút thắt hiệu suất khác đối với khối lượng công việc AI. Vì vậy, hầu hết các hệ thống sử dụng ổ đĩa NVMe cục bộ thay vì ổ SSD SATA.

IRender - Dịch vụ điện toán đám mây có thể cung cấp cho bạn những gì?

GPU đã là công cụ hỗ trợ cho hầu hết các khối lượng công việc AI và Nvidia đã cải thiện đáng kể hiệu suất DL của họ thông qua các tính năng như Tensor Cores, Multi-instance GPU (để chạy nhiều quá trình song song và kết nối NVLink GPU). Tuy nhiên, nhu cầu về tốc độ và hiệu quả ngày càng tăng đã tạo ra một loạt các bộ xử lý AI mới như TPU của Google, Bộ xử lý Intel Habana AI, Bộ xử lý đa năng Tachyum, Wave AI SoC hoặc các giải pháp dựa trên mảng cổng lập trình trường (FPGA) như Microsoft Brainwave, một nền tảng học sâu dành cho AI trên đám mây.

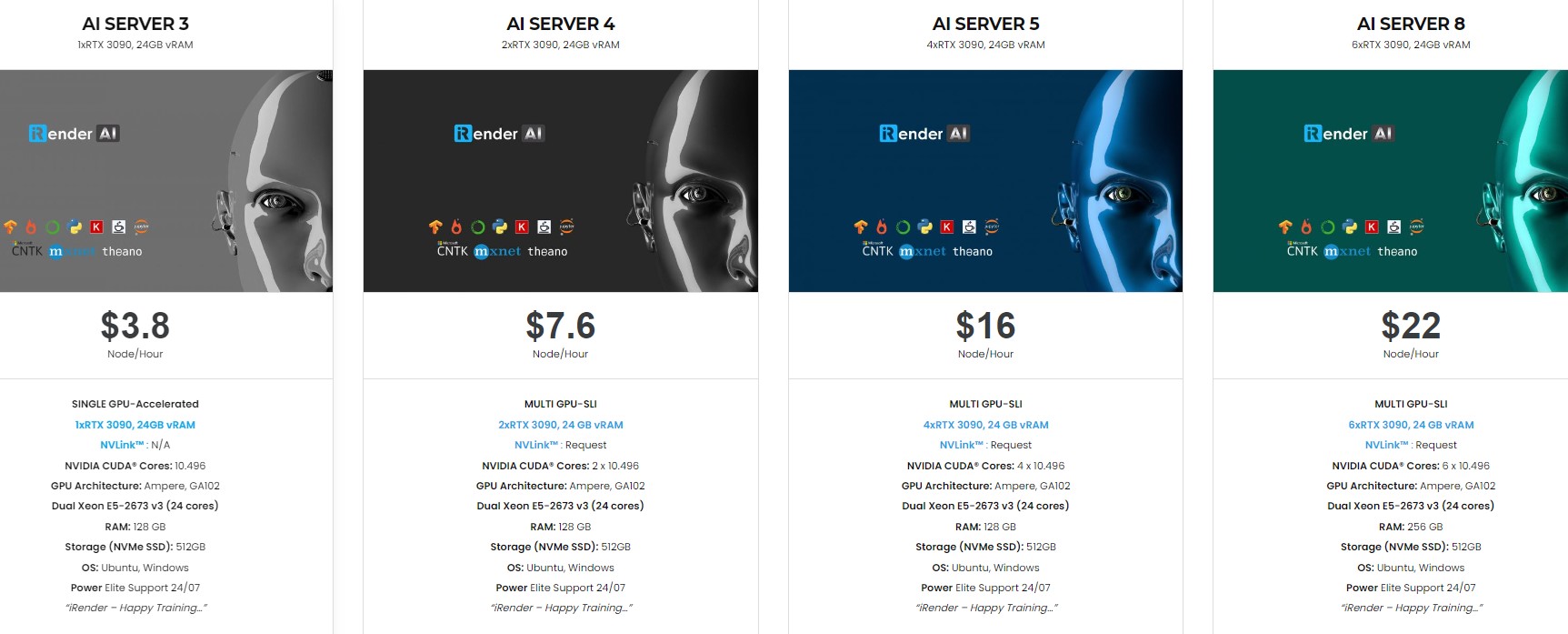

Doanh nghiệp có thể sử dụng bất kỳ cơ sở hạ tầng siêu hội tụ hoặc hệ thống mật độ cao nào cho AI bằng cách chọn cấu hình và thành phần hệ thống phù hợp. Và, một trong những lựa chọn có thể là dịch vụ đám mây GPU với tên gọi iRender. Hãy cùng xem các gói máy chủ đám mây GPU của iRender bên dưới:

Tại iRender, chúng tôi cung cấp giải pháp nhanh chóng, mạnh mẽ và hiệu quả cho người dùng Deep Learning với cấu hình gói từ 1 đến 6 GPU RTX 3090 trên cả hai hệ điều hành Windows và Ubuntu. Ngoài ra, chúng tôi còn có GPU cấu hình gói từ 1 RTX 3090 và 8 x RTX 3090. Với dịch vụ hỗ trợ chuyên nghiệp 24/7, công cụ lưu trữ và truyền dữ liệu mạnh mẽ, miễn phí và tiện lợi – GPUhub Sync, cùng với chi phí phải chăng giúp công việc quả bạn hiệu quả hơn.

Đăng ký tài khoản ngay hôm nay để trải nghiệm dịch vụ của chúng tôi. Hoặc liên hệ với chúng tôi, tôi thông qua Zalo: (+84) 912 785 500 để được tư vấn và hỗ trợ.