5 phút để hiểu hơn về Deep Learning (Phần 1)

Học sâu (Deep Learning) là một lĩnh vực con của học máy (Machine Learning) liên quan đến các thuật toán lấy cảm hứng từ cấu trúc và chức năng của não được gọi là mạng thần kinh nhân tạo (artificial neural networks).

Các nhà lãnh đạo và chuyên gia trong lĩnh vực này có nhiều góc nhìn về Deep Learning và thực tế những góc nhìn cụ thể và mang nhiều sắc thái này đã và đang làm sáng tỏ nhiều bí ẩn về Deep Learning.

Trong bài đăng này, bạn sẽ khám phá chính xác Deep Learning là gì bằng cách lắng nghe ý kiến của hàng loạt chuyên gia và nhà lãnh đạo trong lĩnh vực này.

Thế tóm lại Deep Learning là gì?

Andrew Ng, làm tại Coursera và là Nhà khoa học trưởng (Chief Scientist) tại Baidu Research đã chính thức thành lập Google Brain, công ty sản xuất công nghệ Deep Learning trên một số lượng lớn các dịch vụ của Google đã có nhiều bài nói và viết về Deep Learning và cho biết rằng đây là một lĩnh vực đáng để bắt đầu học.

Trong bài nói chuyện năm 2013 với tiêu đề “ Học sâu, Tự học và Học tính năng không giám sát” (Deep Learning, Self-Taught Learning and Unsupervised Feature Learning), ông đã bày tỏ quan điểm về Deep Learning rằng: “Việc sử dụng mô phỏng não được kỳ vọng sẽ giúp học các thuật toán tốt hơn và dễ sử dụng hơn nhiều, tạo ra những tiến bộ mang tính cách mạng trong Học máy và Trí tuệ nhân tạo. Tôi tin rằng đây là bước tiến tuyệt nhất của chúng tôi trong quá trình hướng tới trí tuệ nhân tạo thực sự.”

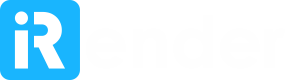

Tiếp đó ông cũng đưa ra thêm nhiều bình luận sắc bén hơn hơn. Rằng cốt lõi của Deep Learning theo Andrew là giờ đây chúng ta có máy tính đủ nhanh và đủ dữ liệu để thực sự đào tạo số lượng lớn neural network. Khi thảo luận về lý do tại sao bây giờ là thời điểm mà Deep Learning nên được chú trọng tại ExtractConf 2015 với bài diễn thuyết “Các nhà khoa học dữ liệu nên biết gì về học sâu” (What data scientists should know about deep learning), ông đề cập đến vấn đề các neural network rất lớn mà chúng ta có thể có và lượng dữ liệu khổng lồ mà chúng ta có thể truy cập vào. Mấu chốt ở đây là quy mô. Khi nhóm của ông xây dựng các neural network lớn hơn và đào tạo chúng với ngày càng nhiều dữ liệu hơn, hiệu suất của chúng sẽ tiếp tục tăng lên. Điều này thường khác với các kỹ thuật Machine Learning khác khi đạt được hiệu suất cao.

Deep Learning là Học tính năng phân cấp (Hierarchical Feature Learning)

Ngoài khả năng mở rộng, một lợi ích khác thường được trích dẫn của các mô hình Deep Learning là khả năng thực hiện trích xuất tính năng tự động (automatic feature extraction) từ dữ liệu thô, còn được gọi là học tính năng (feature learning).

Yoshua Bengio là một nhà lãnh đạo khác trong lĩnh vực Deep Learning với sự quan tâm mạnh mẽ đến automatic feature learning mà các neural network lớn có khả năng đạt được. Ông mô tả Deep Learning theo khía cạnh thuật toán để khám phá và học các cách biểu diễn tốt bằng cách sử dụng feature learning. Trong bài báo năm 2012 của ông với tiêu đề “Học sâu về sự đại diện cho việc học không được giám sát và chuyển giao” (Deep Learning of Representations for Unsupervised and Transfer Learning), ông viết: “Các thuật toán học sâu tìm cách khai thác cấu trúc chưa biết trong phân phối đầu vào để khám phá các biểu diễn tốt, thường ở nhiều cấp độ, với các tính năng đã học ở cấp cao hơn được xác định theo các tính năng cấp thấp hơn”.

Báo cáo kỹ thuật năm 2009 của ông có tiêu đề “Học kiến trúc sâu cho AI” (Learning deep architectures for AI) nhấn mạnh tầm quan trọng của hệ thống phân cấp trong học tính năng (hierarchy in feature learning).

Trong cuốn sách sắp được xuất bản có tựa đề “Deep Learning” đồng tác giả với Ian Goodfellow và Aaron Courville, họ định nghĩa Deep Learning theo góc độ độ sâu của kiến trúc của các mô hình. Hệ thống phân cấp các khái niệm cho phép máy tính học các khái niệm phức tạp bằng cách xây dựng chúng từ những khái niệm đơn giản hơn. Nếu chúng ta vẽ một biểu đồ cho thấy các khái niệm này được xây dựng chồng lên nhau như thế nào, thì biểu đồ đó rất sâu, có nhiều layer. Vì lý do này, các tác giả gọi cách tiếp cận này là AI Deep Learning.

Đây là một cuốn sách quan trọng và có thể sẽ trở thành nguồn tài liệu chính yếu cho lĩnh vực này trong một thời gian. Cuốn sách tiếp tục mô tả các perceptron nhiều layer như một thuật toán được sử dụng trong lĩnh vực Deep Learning rằng Deep Learning đã phụ thuộc vào các neural network nhân tạo.

Peter Norvig là Giám đốc Nghiên cứu của Google và nổi tiếng với cuốn sách giáo khoa về AI có tiêu đề “Artificial Intelligence: A Modern Approach“. Trong một bài nói chuyện năm 2016 với chủ đề “Học sâu và khả năng hiểu so với Kỹ thuật phần mềm và Xác minh” (Deep Learning and Understandability versus Software Engineering and Verification), ông đã định nghĩa Deep Learning theo cách rất giống với Yoshua, tức là tập trung vào sức mạnh của tính trừu tượng được cho phép bằng cách sử dụng cấu trúc mạng sâu hơn. Ông cho rằng đây là một kiểu học trong đó biểu diễn bạn tạo có một số cấp độ trừu tượng, chứ không phải là đầu vào trực tiếp cho đầu ra.

Tại sao lại gọi là Deep Learning mà không gọi là “Artificial Neural Network”?

Geoffrey Hinton là nhà tiên phong trong lĩnh vực Artificial Neural Network và đã đồng xuất bản bài báo đầu tiên về thuật toán truyền ngược (backpropagation algorithm) để đào tạo mạng perceptron nhiều layer.

Ông ấy đã bắt đầu giới thiệu cụm từ “deep” để mô tả sự phát triển của artificial neural network lớn.

Ông là đồng tác giả của một bài báo vào năm 2006 với tiêu đề “Một thuật toán học nhanh cho niềm tin sâu” (“A Fast Learning Algorithm for Deep Belief Nets”) – mô tả một cách tiếp cận để đào tạo “sâu” (như trong một mạng lưới nhiều layer) của các máy Boltzmann bị hạn chế.

“Sử dụng complementary priors, chúng tôi tạo ra một thuật toán nhanh có thể học mạng sâu, có định hướng từng lớp một, miễn là hai lớp trên cùng tạo thành một bộ nhớ liên kết vô hướng (an undirected associative memory).”

Bài báo này và bài báo liên quan do Geoff đồng tác giả có tựa đề “Deep Boltzmann Machines” về một mạng lưới sâu không định hướng (undirected deep network) đã được cộng đồng đón nhận nồng nhiệt (hiện đã được trích dẫn hàng trăm lần) vì chúng là những ví dụ thành công về việc đào tạo mạng lưới theo lớp khôn ngoan (layer-wise) cho phép nhiều layer khác hơn trong mạng truyền thẳng (feedforward network).

Trong một bài báo đồng tác giả trên tạp chí Science có tiêu đề “Giảm chiều dữ liệu với mạng thần kinh” (Reducing the Dimensionality of Data with Neural Networks) họ cũng sử dụng chung một mô tả “sâu” (deep) để mô tả cách tiếp cận của họ để phát triển mạng với nhiều layer hơn so với các loại thông thường trước đây. Họ đã mô tả một cách hiệu quả để khởi tạo các trọng số cho phép các mạng mã tự động sâu (deep autoencoder networks) để tìm hiểu các mã chiều thấp (low-dimensional codes) mà hoạt động tốt hơn nhiều so với việc phân tích các thành phần chính như một công cụ để giảm thứ nguyên của dữ liệu (dimensionality of data).

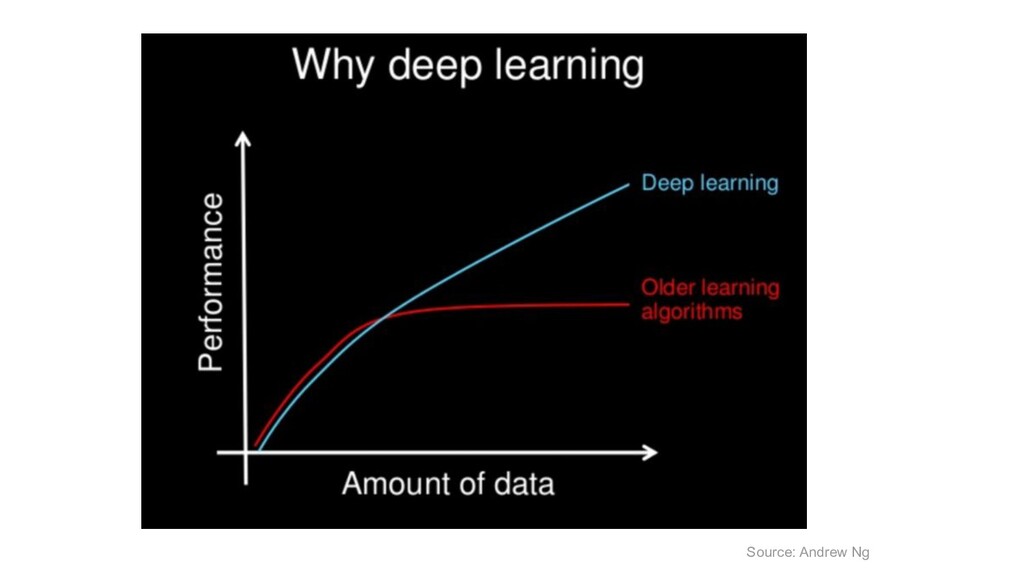

Trong bài báo, họ cũng đưa ra một nhận xét thú vị trùng khớp với nhận xét của Andrew Ng về sự gia tăng gần đây về sức mạnh tính toán và quyền truy cập vào các tập dữ liệu lớn đã giải phóng khả năng chưa được khai thác của mạng thần kinh khi được sử dụng ở quy mô lớn hơn.

Rõ ràng là kể từ những năm 1980 rằng backpropagation thông qua các bộ mã tự động sâu (deep autoencoders) sẽ rất hiệu quả để giảm chiều dữ liệu phi tuyến tính (nonlinear dimensionality reduction), với điều kiện là máy tính đủ nhanh, tập dữ liệu đủ lớn và trọng số ban đầu đủ gần với một giải pháp tốt. Và cả ba điều kiện trên đều đã được thỏa mãn.

Vẫn còn nữa ...

Ở phần tiếp theo, chúng ta sẽ cùng nhau tìm hiểu tiếp về Deep Learning. Các bạn hãy cùng đón chờ nhé!

Deep Learning ngày càng đóng vai trò quan trọng trong việc ứng dụng công nghệ ngày nay. Để tăng hiệu suất làm việc với Deep Learning thì không thể thiếu một chiếc máy tính có cấu hình thật mạnh đúng không nào!

iRender là công ty công nghệ điện toán đám mây (Cloud computing) của Việt Nam cung cấp các dịch vụ phục vụ cho Deep Learning/AI trên nền tảng điện toán đám mây (Cloud Rendering) với nền tảng hệ thống được đầu tư bài bản và mạnh mẽ nhất với 20.000 Cores hỗ trợ song song sức mạnh điện toán của CPUs và GPUs.

iRender có đội ngũ nhân viên nhiệt tình luôn sẵn sàng hỗ trợ bạn 24/7. Bất cứ khi nào bạn gặp sự cố khi sử dụng máy chủ của chúng tôi hoặc thậm chí với phần mềm của bạn, chúng tôi – iRender Support Team luôn sẵn sàng trợ giúp bạn giải quyết vấn đề của mình. Chúng tôi cung cấp hỗ trợ chưa từng có phù hợp với nhu cầu và mục tiêu cụ thể của bạn.

Với tất cả những ưu điểm vượt trội kể trên, chắc hẳn bạn đã tìm được cho mình sự lựa chọn hoàn hảo cho iRender . Chúng tôi tin rằng chất lượng hỗ trợ mà chúng tôi cung cấp cũng quan trọng như công nghệ mà chúng tôi cung cấp. Chúng tôi cung cấp hỗ trợ chưa từng có phù hợp với nhu cầu và mục tiêu cụ thể của bạn. ƯU ĐÃI ĐẶC BIỆT cho tháng 10 này: Tặng 50% GIÁ TRỊ NẠP cho tất cả người dùng mới đăng ký. Hãy cùng kiểm tra nào!

iRender – Happy iRender!

Nguồn và ảnh: machinelearningmastery.com